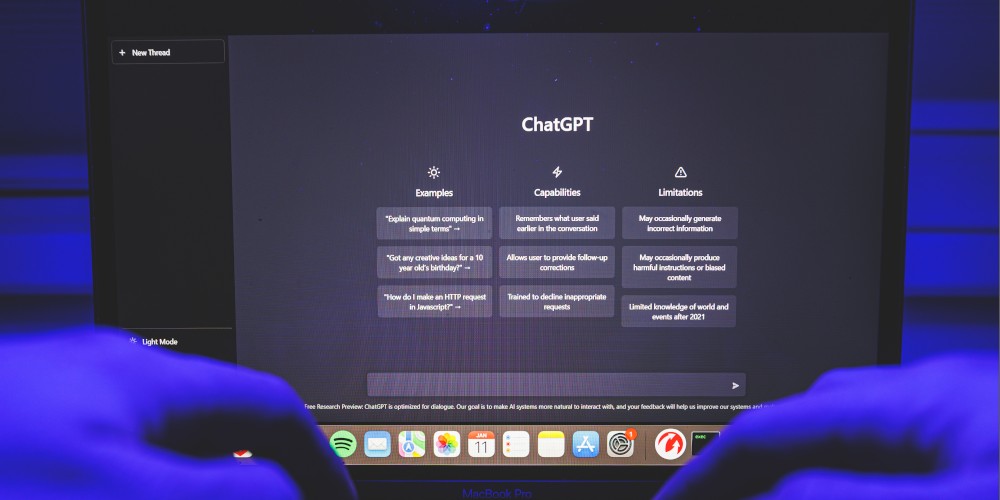

In einer zunehmend digitalisierten Welt werden zukünftig auch Künstliche Intelligenz (KI) und maschinelles Lernen zu zentralen Bestandteilen unseres Kanzleialltags werden. Microsoft Bing Chat, Google Bard und ChatGPT (Generative Pre-trained Transformer) sind derzeit wohl die bekanntesten und verbreitetsten KI-Chatbots. Dabei spielt Microsoft auch bei ChatGPT eine Rolle, erst im Januar dieses Jahres gab Microsoft eine Partnerschaft mit OpenAI bekannt. Es gibt ähnlich strukturierte KI-Modelle, z. B. den europäischen Open Source Chatbot „Open Assistant“, auf welche die nachfolgend dargestellten Erkenntnisse gleichsam anwendbar sind.

Während Google Bard dazu entwickelt wurde, Gedichte und lyrische Texte zu generieren, die kaum von denen eines menschlichen Autors zu unterscheiden sind, ist ChatGPT darauf spezialisiert, interaktive Gespräche zu führen und Antworten auf eine Vielzahl von Fragen zu geben. Beide KI-Modelle basieren auf riesigen Datensätzen, die aus dem Internet extrahiert wurden, was ihnen eine beeindruckende Fähigkeit verleiht, menschenähnlichen Content zu produzieren.

Trotz der faszinierenden Anwendungsmöglichkeiten, sind derzeit zahlreiche Fragen, insbesondere zu Datenschutz und -sicherheit sowie Urheberrecht, aber auch im Hinblick auf den Wahrheitsgehalt und die Nachprüfbarkeit der Antworten, die ein solcher Chatbot liefert, noch nicht abschließend geklärt. In diesem Beitrag soll ein Blick auf die datenschutzrechtlichen Aspekte geworfen werden, denn die Fähigkeiten dieser KI-Modelle bringen eine Reihe von Datenschutzherausforderungen mit sich.

Bevor ich jedoch zu den rechtlichen Gesichtspunkten komme, gebe ich zunächst einmal einen kurzen Überblick darüber, was Rechtsanwältinnen und -anwälte mit einem solchen KI-Chatbot überhaupt anfangen können.

Rechtsanwältinnen und Rechtsanwälte können KI-Chatbots auf verschiedene Arten nutzen, um ihre Arbeit effizienter und effektiver zu gestalten. Nachfolgend stelle ich am Beispiel von ChatGPT einige Möglichkeiten vor, wie KI-Chatbots in der juristischen Praxis sinnvoll eingesetzt werden können:

- Recherche und Rechtsauslegung: ChatGPT kann verwendet werden, um umfangreiche Recherchen durchzuführen und rechtliche Fragestellungen zu klären. So können Anwältinnen und Anwälte Fragen formulieren und von ChatGPT relevante Fallgesetze, Präzedenzfälle, rechtliche Theorien und Argumentationsansätze erhalten.

- Verfassen von Rechtsdokumenten: ChatGPT kann beim Verfassen von Rechtsdokumenten, wie Verträgen, Schriftsätzen, Gutachten und Rechtsausführungen, unterstützen. Die Anwenderin oder der Anwender kann den Inhalt grob skizzieren und ChatGPT um Vorschläge für die Formulierung bitten.

- Kommunikation mit der Mandantschaft: Die unter Ziff. 1 dargestellte Grobrecherche kann dazu genutzt werden, um Anfragen von Mandantinnen und Mandanten zu beantworten. Auf diese Weise können schnell erste, vorläufige rechtliche Einschätzungen abgegeben oder allgemeine rechtliche Informationen vermittelt werden, ohne dass lange in der Fachliteratur gesucht werden muss. Dabei sind die von ChatGPT formulierten Antworten zumeist in einfacher, mandantengerechter Sprache verfasst.

- Vorbereitung von Gerichtsverhandlungen: ChatGPT kann bei der Vorbereitung von Gerichtsverhandlungen helfen, indem es bei der Formulierung von Argumenten Fragen an Zeuginnen und Zeugen und rechtlichen Standpunkten unterstützt.

- Einschätzung von Rechtsrisiken: Anwältinnen und Anwälte können ChatGPT verwenden, um potenziell rechtliche Risiken in verschiedenen Szenarien zu bewerten. Dies kann bei der Entscheidungsfindung und der Beratung der Mandantschaft hilfreich sein.

- Fortbildung und Weiterbildung: ChatGPT kann als Lernwerkzeug dienen, um sich über neue rechtliche Entwicklungen, Gesetzesänderungen und aktuelle Rechtsprechung auf dem Laufenden zu halten.

- Generelle Rechtsfragen: Anwältinnen und Anwälte können ChatGPT verwenden, um allgemeine rechtliche Fragen zu klären, die möglicherweise keine spezifische Recherche erfordern. Dies kann Zeit sparen, insbesondere wenn es sich um grundlegende Informationen handelt.

Wichtig ist jedoch zu beachten, dass ChatGPT als KI-Technologie nicht als Ersatz für professionelle juristische Beratung oder Expertise dienen sollte. Rechtsanwältinnen und -anwälte sollten die von ChatGPT bereitgestellten Informationen stets kritisch prüfen und ihre eigenen rechtlichen Kenntnisse und Erfahrungen einbringen, um genaue und angemessene Ratschläge zu geben.

Außerdem ist für die Qualität des Ergebnisses vor allem die Qualität der Frage bzw. der Anweisung entscheidend. Diese sollte so eindeutig formuliert sein, dass darauf eine konkrete und eindeutige Antwort gegeben werden kann. Je genauer die Fragestellung ist, umso exakter wird die Antwort ausfallen. Im Netz finden sich zudem einige gute Anleitungen, wie man das gesamte Potenzial der KI freisetzen kann.

Verarbeitung personenbezogener Daten durch die KI-Chatbots

Die Funktionsweise von KI-Modellen, wie Google Bard und ChatGPT, basiert auf dem Trainieren mit umfangreichen Datensätzen. Dies erfordert, dass große Mengen an Daten gesammelt und gespeichert wurden, um überhaupt eine Datenbasis für die KI zu schaffen. Um diese Datenbasis stets aktuell zu halten – und vor allem, um genauere Ergebnisse erzielen zu können, saugen die KI-Modelle ständig weiter nach allen möglichen Daten. Quellen dieser Daten sind dabei erstens alle im Internet öffentlich zugänglichen Daten und zweitens die Daten der Nutzer, die diese bei der Interaktion mit den Chatbots preisgeben.

Hier liegen die ersten Probleme, denn nicht alles, was im Internet veröffentlicht wird, darf so einfach für andere Zwecke durch Dritte genutzt werden. Anders ausgedrückt: Wenn ein Name einer natürlichen Person im Impressum einer Website veröffentlicht ist, dann geschieht dies, weil diese dazu rechtlich verpflichtet ist. Das bedeutet aber keineswegs, dass OpenAI oder Microsoft dieses Datum für ihre KI-Modelle nutzen darf.

ChatGPT und die italienische Datenschutzaufsichtsbehörde

Die italienische Datenschutzaufsichtsbehörde „Garante per la protezione dei dati personali“ hatte ChatGPT am 31. März dieses Jahres als erste und einzige europäische Datenschutzaufsicht vorübergehend gesperrt. Grund für diese Maßnahme war ein am 20. März 2023 gemeldetes Datenleck, das Nutzerdaten und Zahlungsinformationen betraf. Darüber hinaus erkannten die italienischen Datenschützer zahlreiche Verletzungen der DSGVO. So seien den Nutzerinnen und Nutzern von ChatGPT und den betroffenen Personen, deren Daten durch OpenAI gesammelt werden, keine hinreichenden Informationen hierüber zur Verfügung gestellt worden. Zudem fehle es an einer Rechtsgrundlage für die massive Sammlung und Verarbeitung personenbezogener Daten, die für das Training der Algorithmen genutzt würden. Auch war den italienischen Datenschützern nicht klar, wie OpenAI den Jugendschutz gewährleiste.

Erst nachdem OpenAI die Nutzungsbedingungen überarbeitet und eine Altersprüfung eingeführt hatte, hob Italien die Sperrung von ChatGPT am 29. April 2023 wieder auf.

Dennoch sind einige Fragen bislang unbeantwortet geblieben, insbesondere was das Sammeln und Verarbeiten von personenbezogenen Daten betrifft.

Ansicht anderer Datenschutzaufsichtsbehörden

Der Bundesbeauftragte für den Datenschutz in Deutschland teilte Anfang April 2023 mit, dass ein vergleichbares Vorgehen, also ein Verbot bzw. eine Sperre der Nutzung von ChatGPT auch in Deutschland möglich sei. Allerdings sei dies nicht von ihm, sondern durch die hierfür zuständigen Landesdatenschutzbehörden auf Länderebene zu entscheiden. Nach derzeitigem Kenntnisstand stehen die Landesdatenschutzbeauftragten sowohl untereinander als auch mit der italienischen Datenschutzbehörde in Verbindung und werten aktuell die vorhandenen Erkenntnisse aus. Die Nutzung von ChatGPT für Nutzerinnen und Nutzer aus Deutschland ist daher zunächst weiterhin möglich.

Ebenfalls im April hat auch der Europäische Datenschutzausschuss („EDSA“) offiziell mitgeteilt, dass die Mitglieder des Datenschutzausschusses über ChatGPT diskutieren würden. Konkrete Ergebnisse liegen auch hier noch nicht vor. Jedoch haben die Mitglieder des EDSA entschieden, eine spezielle Task Force einzurichten, um die Zusammenarbeit der Datenschutzbehörden aus den einzelnen EU-Mitgliedstaaten zu fördern und Informationen über mögliche datenschutzrechtliche Durchsetzungsmaßnahmen auszutauschen, die die Datenschutzbehörden ergreifen könnten. Dies könnte durchaus zu einer schnelleren Umsetzung von Sperrungen, Verboten oder sonstigen Maßnahmen in allen EU-Mitgliedsstaaten führen – oder auch zu einem erneuten Verbot einer KI-Anwendung.

Nutzung von KI-Chatbots in Anwaltskanzleien und Unternehmen

Der Anwendungsbereich der Datenschutzgesetze (DSGVO, BDSG) ist nur dann eröffnet, wenn personenbezogene Daten verarbeitet werden. Wenn also Anwaltskanzleien oder deren Mandantinnen und Mandanten einen KI-Chatbot nutzen, ist folglich eine Interaktion jedenfalls dann unbedenklich, wenn keine personenbezogenen Daten in den Chat eingegeben werden.

Dabei ist jedoch zu beachten, dass es häufig nicht damit getan ist, nur die unmittelbar identifizierenden Merkmale bei der Eingabe der Frage zu vermeiden. Wenn der Sachverhalt, den man eingibt, zahlreiche mittelbar identifizierbare Merkmale enthält, besteht gerade bei den hoch entwickelten Algorithmen und angesichts der Lernfähigkeit der KI das Risiko, dass diese Personen mit dem Sachverhalt in Verbindung gebracht und auf diese Weise nicht nur identifiziert, sondern dass diese Daten möglicherweise auch mit anderen Quellen verbunden und so Profile gebildet werden. Möglicherweise zieht sich die KI ohne das Wissen des Anwenders, z. B. über dessen Website oder Social Media-Auftritte, weitere Informationen, sodass letztlich durch das Vermeiden von unmittelbar identifizierenden Daten lediglich eine Pseudonymisierung, nicht aber eine Anonymisierung erreicht wird. Will die Anwenderin oder der Anwender das nicht, um nicht in den Anwendungsbereich der Datenschutzgesetze zu kommen, so muss sie oder er ggf. die Frage so stark abstrahieren, dass die KI keine ausreichend konkrete und verwertbare Antwort liefern kann.

Es wird zudem dringend empfohlen, den Einsatz von KI-Chatbots mit den Mitarbeiterinnen und Mitarbeitern zu regeln. Ein Verbot dürfte sich kaum durchsetzen lassen, zumal die KI den Kanzleialltag durchaus bereichern und, wie die oben aufgezählten Anwendungsbeispiele zeigen, bisweilen auch erleichtern dürfte.

Dabei kommt es letztlich nicht darauf an, ob das Ganze über den Arbeitsvertrag, eine Richtlinie oder eine Verpflichtungserklärung geregelt wird. Wichtig ist, dass der Arbeitgeber im Zweifel nachweisen kann, dass er seine Mitarbeiterinnen und Mitarbeiter über den rechtskonformen Umgang mit KI-Chatbots, wie ChatGPT, Bing Chat oder Bard, belehrt und darauf hingewiesen hat, dass man keine Daten eingeben darf, aus denen unmittelbar oder auch nur mittelbar auf eine natürliche Person geschlossen werden kann. Verstößt ein Mitarbeiter dennoch gegen eine solche eindeutige und unmissverständliche Weisung, wird im Regelfall die Verantwortung vom Arbeitgeber auf den Mitarbeiter übergehen. Dann spricht man von einem sogenannten Mitarbeiterexzess.

Die Weiterentwicklung von KI-Technologien wie Google Bard und ChatGPT ist zweifellos faszinierend, aber es ist von entscheidender Bedeutung, dass diese Entwicklungen im Einklang mit den Prinzipien des Datenschutzes und der ethischen Verantwortung stehen. Nur so wird sich auf Dauer sicherstellen lassen, dass alle Arten von KI-Systemen und Anwendungen die Gesellschaft positiv beeinflussen und gleichzeitig die Privatsphäre und Sicherheit der Nutzerinnen und Nutzer gewahrt werden.

Übrigens: Der Verfasser hat diesen Beitrag unter tätiger Mithilfe von ChatGPT erstellt.

Rainer Robbel ist Rechtsanwalt in der Kanzlei ETL-Rechtsanwälte GmbH, Niederlassung Köln. Er ist als Datenschutzauditor (Bitkom-zert.) und externer Datenschutzbeauftragter (TÜV-zert.) für zahlreiche verschiedene Unternehmen tätig.